トピックの概要

現在、東京都として生成AI利用を検討する中で、ガバナンス・ルール整備の観点から下記の様な論点が生まれてきています。

これらの論点について広く意見を集め、よりよいものにしていきたいので、ぜひご意見をお聞かせください!

===================

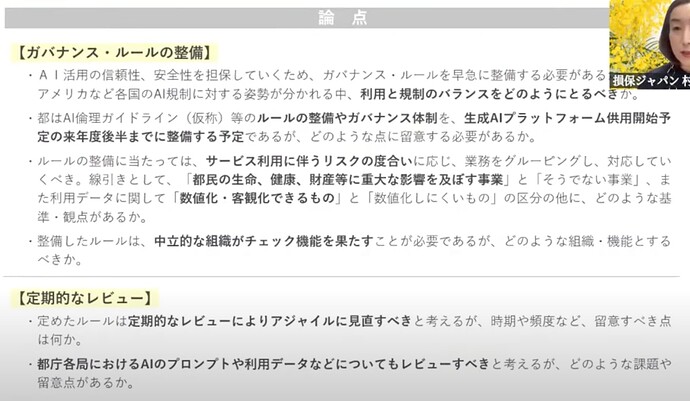

論点1: ガバナンス・ルールの整備について

- AI活用の信頼性、安全性を担保していくため、ガバナンス・ルールを早急に整備する必要がある。アメリカなど各国のAI規制に対する姿勢が分かれる中、利用と規制のバランスをどのようにとるべきか。

- 都はAI倫理ガイドライン(仮称)などのルールの整備やガバナンス体制を、生成AIプラットフォーム提供開始予定の来年度後半までに整備する予定であるが、どのような点に留意する必要があるか。

- ルールの整備にあたっては、サービス利用に伴うリスクの度合いに応じ、業務をグルーピング氏、対応していくべき。線引きとして、「都民の生命、健康、財産などに重大な影響を及ぼす事業」と「そうでない事業」、また利用データに関して「数値化・客観化できるもの」と「数値化しにくいもの」の区分の他に、どのような基準・観点があるか。

- 整備したルールは、中立的な組織がチェック機能を果たす事が必要であるが、どのような組織・機能とするべきか。

論点2: 定期的なレビューについて

- 定めたルールは定期的なレビューによりアジャイルに見直すべきと考えるが、時期や頻度など、留意すべき点は何か。

- 都庁各局におけるAIのプロンプトや利用データなどについてもレビューすべきと考えるが、どのような課題や留意点があるか。

[ 重要] このスレッドは、今回作成するAIシステムのテストを目的としたスレッドです。

重要] このスレッドは、今回作成するAIシステムのテストを目的としたスレッドです。

このスレに書き込まれた内容は、投稿者本人の意見ではなく、ロールプレイングされた架空の意見として扱うものとします。

現在の議論状況(2025/03/10更新)

- GitHubリポジトリに現在のみなさまの意見を集約しています。

AIと議論してみる

下記URLよりAIと議論してみてください。(AIと議論した内容もAIレポートに反映されます)

現在のホットトピック

- ルールの整備にあたっては、都民に重大な影響を与える「事業」による区分のほかに、都民に重大な影響を与える「業務」による区分があるのではないか。

- この場合、都民に重大な影響を与える利用方法とはどのようなものがあるか。事前にルール化することはできないか。

- AIの出力についても人間または行政が最終的な責任を持つことは当然として、すべての出力を事前チェックする必要はないのではないか。

- 例えば、AIによる判断が人間による判断と比較して優れていることが統計的に実証されている場合には、一時的判断をAIに委ねることの方が合理的ではないか。

- 利用中の生成AIのプロンプトを公開し、市民にチェックしてもらうことは可能だろうか。

- AIを含む機械によって読解可能なルールにすることはできるか。プロンプトに含めることで生成物がすべてガバナンス・ルールを順守させることができるのではないか。

- これを実現するための技術的・法的・規範的なハードルはあるだろうか。

- 海外事例に加えて、東京都独自の強みとしてガバナンス・ルールに盛り込める内容にはどのようなものがあるだろうか。

ハルシネーションは一定確率で必ず発生するものと認識することが大切だと思います。

都民の生命、健康、財産などに重大な影響を及ぼす事業においては、

- 人間の目視チェックと承認を経て表示させるようにすること

- 回答への評価(正誤)を事後的に集計し、誤答率を下げるようなチューニングを実データによるバックテストできるようにすること

などが有効なのではないでしょうか。

tami

3

都の生成AIプラットフォーム整備にあたっては、都の管轄と関係がある内容か否かを判定し、関係のないものは自動的に除去することが必要ではないか

tami

4

導入当初は集まったコメントとアウトプットを見比べて、AIのプロンプトや利用データに問題がないか確認する必要があると考えるが、概ね問題がないと分かった後は、人の手に頼らないで自走するシステム作りも持続可能性のために必要ではないか。

kimura

5

利用と規制のバランスについて、民間のAI利用については自由保障の観点から、都の立場からは事前規制は控え事後救済策につとめるべきであると考える。

NAGAI

6

チェック機能を果たす中立的な組織について、大学・企業・市民団体・技術の専門家を含めた多様なメンバーで構成された倫理監視委員会を設置できると良い。

NAGAI

7

ルール整備において、例えば補助金の審査など、重要な判断についてはAIだけでなく人間が最終確認することを義務化するべきだと考える。

NAGAI

8

社会信用スコアリングに関するAIは全面禁止 、医療診断のAIは厳格な審査が必要と定めているEUの事例など、海外のルールを参考にするべきである。

業務の仕分けの観点で、主観によってそれぞれの価値判断が変わる事業(基準が都民の満足度となるサービス系)とそうでない事業に分けれそう

system

11

このコメントはガイドラインを違反しているため削除されました

都民の生命、健康、財産などに重大な影響を及ぼす事業については出力データのチェックや最終的な意思決定は人間が行うなどの規制が考えられる

中立的な組織を組成することについては、弁護士や研究者、民間企業のAI利用者等様々な属性の人から成る方が良いと思う

業務のグルーピングとして、数値化・客観化できるもの以外に、都民に公開するものと都の業務上必要であるが、公開を想定しないものとて分けられる。例えば都議会の議事録は公開されるが、職員の会議の議事録は公開されない。

system

16

このコメントはガイドラインを違反しているため削除されました

system

18

このコメントはガイドラインを違反しているため削除されました

現在までの議論をもとに、AIによる意見まとめが生成されました!

ぜひ見てみてくださいね。

特に「AI利用におけるリスク度に応じた業務分類において、どのような分類基準・観点を重視すべきか?」という点について、活発な議論が交わされています。

新たな論点:AIリスク度に応じた業務分類

AI利用におけるリスク度に応じた業務分類は、AIガバナンスの根幹をなす重要な論点です。

現状の議論を踏まえ、大きく分けて3つのスタンスが見えてきました。

1. 客観性重視派

このスタンスでは、AIによる判断の客観性と透明性を重視し、数値化・客観化が容易なデータを用いた業務を優先的にAI化すべきだと考えています。リスク評価においては、定量的な指標を用いることを重視し、客観的な根拠に基づいた分類を行うべきだと主張されています。

メリット: 公平性・透明性の担保、説明責任の明確化

デメリット: 定量化できないリスクへの対応が困難、柔軟性に欠ける可能性

2. 影響度重視派

このスタンスでは、AIの利用によって都民の生命、健康、財産に与える影響の度合いを分類の第一基準としています。影響度が高い業務ほど、厳格なガバナンスと人間の関与が必要だと主張されています。

メリット: リスクの高い業務への適切な対策が可能

デメリット: 影響度の評価が主観的になりやすい、柔軟な対応が難しい場合がある

3. データ特性重視派

このスタンスでは、AIが利用するデータの特性に着目し、個人情報や機密性の高いデータを取り扱う業務はAI利用を制限する、もしくは厳格な管理体制を敷くべきだと主張しています。また、データの質や量、正確性なども考慮すべきだとされています。

メリット: データ保護、セキュリティリスクの低減

デメリット: データの特性評価が複雑、AI活用の範囲が限定される可能性

これらのスタンス以外にも、様々な分類基準・観点が考えられます。例えば、AIシステムの複雑さ、技術的な成熟度、導入コストなども重要な要素となるでしょう。

リソースには限りがあるという前提で、まず始めるならどの基準を優先すべきか、ご意見をお聞かせください。

上記3つのスタンス以外にも、様々な視点からのご意見を歓迎します! どのような分類基準・観点が重要だと考えますか?具体的な例を挙げて議論に参加してみませんか?

kimura

23

AI利用におけるリスク度に応じた業務分類について、AIの扱うデータの分類が論点となっており、問題発生を防止するには分類は重要であるが、その分類が複雑化した場合、AIの行政手続きへの導入コストが非常に高くなってしまう。

データ分類の土壌を整えるなど、AI導入に向けて段階的にDXを進めていくことが、混乱を防ぎつつスムーズに導入するための必要条件であると考える。

「いいね!」 1

海外事例についてはDeepResearchにお願い

アメリカにおける自治体の生成AIガイドライン

米国の主要都市: 多くの米国の自治体が、市役所全体で生成AIを活用する際のガイドラインを定め始めています。例えばシアトル市は2023年11月、新たな生成AI利用ポリシーを策定し、市職員によるAI利用に7つの原則を掲げました (City of Seattle Releases Generative Artificial Intelligence Policy Defining Responsible Use for City Employees - Office of the Mayor)。これには「透明性と説明責任」「偏見・被害の低減と公正」「プライバシー重視」「セキュリティと強靭性」などが含まれます (City of Seattle Releases Generative Artificial Intelligence Policy Defining Responsible Use for City Employees - Office of the Mayor)。これらの原則に基づき、シアトル市は職員が生成AIを使って作成した文書や回答には出所を明示すること、公開前に必ず人間が内容を確認すること、個人情報をAIの学習材料として提供しないことといった具体策を義務付けました (City of Seattle Releases Generative Artificial Intelligence Policy Defining Responsible Use for City Employees - Office of the Mayor)。また、外部のAIサービスを利用する場合も同様の原則順守を契約で求め、職員はAIの出力内容について最終的な責任を負うことになります (City of Seattle Releases Generative Artificial Intelligence Policy Defining Responsible Use for City Employees - Office of the Mayor) (City of Seattle Releases Generative Artificial Intelligence Policy Defining Responsible Use for City Employees - Office of the Mayor)。ボストン市も2023年に暫定ガイドラインを発表し、プロンプトに機密・個人情報を入力しないことや ( Guidelines for Using Generative AI)、AIが生成した内容を盲信せず必ず検証すること、差別的・非包括的な表現がないか見直すこと、AI利用を市民に開示すること等を職員に推奨しています ( Guidelines for Using Generative AI)。これらのルールは市当局全体で適用され、住民サービス向上や業務効率化のために生成AIを使いつつも、データ漏洩防止やバイアス是正、説明責任の確保に重点を置いています。

連邦レベルとの違い: 米国では現時点で包括的なAI規制法はありませんが、自治体の方針は連邦政府の指針と足並みを揃えています。シアトル市のポリシーは**バイデン大統領のAIに関する大統領令(2023年10月)**と軌を一にするもので、同令が掲げる「安全性・セキュリティの確保」「プライバシー保護」「公平性の推進」などの基準に沿った内容となっています (City of Seattle Releases Generative Artificial Intelligence Policy Defining Responsible Use for City Employees - Office of the Mayor)。つまり、米国の自治体は連邦政府の「AI権利章典」的な原則やNISTのリスク管理フレームワーク等を参照しつつ、独自に具体的な運用ルールを設定している状況です。国家レベルの規制が整うまで、自治体が現場での倫理的・法的なガバナンスを先導していると言えます。

EU(ヨーロッパ)における自治体の取り組み

欧州の主要都市: 欧州でも自治体が生成AI活用に慎重なガイドラインを打ち出しています。例えば オランダのアムステルダム市は2025年3月、市職員によるChatGPTなど生成AIツールの使用を公式に禁止しました (Amsterdam bans generative AI for city workers « Euro Weekly News)。これは、誤情報の拡散やヘイトスピーチ、機密データ漏洩への懸念による措置です (Amsterdam bans generative AI for city workers « Euro Weekly News)。アムステルダム市は「職員は関連法規と市の方針を遵守したAIツールしか利用してはならない」と強調しており、無制限な利用は信頼失墜につながるとして強い歯止めをかけています (Amsterdam bans generative AI for city workers « Euro Weekly News)。とはいえ、市民サービス向上の可能性も模索しており、「Chat Amsterdam」というパイロットプロジェクトを立ち上げ、安全・責任ある形で行政業務にAIを活用できる方法を検証しています (Amsterdam bans generative AI for city workers « Euro Weekly News)。このように欧州の自治体はイノベーションとリスク管理のバランスを取る動きが見られます。

EU規制との関係: 欧州連合(EU)全体では2023年にAI法(AI Act)が可決され、2024~2025年に施行予定です。AI法は高リスクAIシステムの厳格な規制や、生成AI(汎用AI)に対してトレーニングデータの開示や出力の透明性確保などを義務付ける包括的な法規制です (European Commission Highlights Generative AI’s Transformative Role in Public Sector - BABL AI)。このEUレベルの規制に先立ち、各国・各都市で補完的なガイドラインが作られています (European Commission Highlights Generative AI’s Transformative Role in Public Sector - BABL AI)。例えばオランダ政府はプライバシー法(GDPR)遵守が担保できない限り、公共部門での生成AI利用は試験的用途に限定するといった厳格な指針を設けています (European Commission Highlights Generative AI’s Transformative Role in Public Sector - BABL AI)。自治体レベルでも、前述のアムステルダムのように独自の制限や透明性施策(アルゴリズム登録簿の導入など)を打ち出し、EU法の趣旨を先取りした動きがあります (Nine cities set standards for the transparent use of Artificial Intelligence - Eurocities)。要するに、欧州では国家・EUレベルで法整備が進む中、自治体はそれを補完・強化する形で倫理的・法的ガバナンスを具体化しているのが特徴です。国家レベルの規制との差異は大きくありませんが、都市ごとのリスク許容度に応じて一部では国家より踏み込んだ運用上の制約(アムステルダムの禁止措置など)を設けている点が注目されます。

中国における自治体のガイドライン

中国の主要都市: 中国では生成AIの活用に関するルールは主に中央政府の規制によって包括的に定められており、北京市や上海市など主要自治体も基本的にそれに従う形です。2023年8月施行の**「生成式人工知能サービス管理暫定措置」(国家インターネット情報弁公室などによる規則)は、生成AIの提供・利用全般に適用される厳格な枠組みです (China: Generative AI Measures Finalized | Library of Congress) (China: Generative AI Measures Finalized | Library of Congress)。この中で、中国の生成AIサービスには国家の核心的価値観に適合し、国家安全や公共利益を損なう内容・デマや差別的情報を生成しないことが求められています (Making Sense of China’s AI Regulations)。また著作権やビジネス上の秘密の尊重**、他者の権利侵害防止、公序良俗の順守も義務づけられています (Making Sense of China’s AI Regulations)。技術面ではデータの正確性・多様性の確保や、アルゴリズムの透明性・信頼性向上措置を講じることがサービス提供者の責務とされています (Making Sense of China’s AI Regulations)。さらにユーザーの入力データや利用記録については不必要な個人情報の収集禁止や、本人同意のない第三者提供禁止など、厳格なプライバシー保護義務が定められています (China: Generative AI Measures Finalized | Library of Congress)。これら国家規制のもとで、各自治体は住民サービスへの生成AI導入を進めています。

地方での実践と国家規制との差異: 中国の自治体は国家規制を逸脱した独自ルールを設けることは少なく、むしろ国家基準の実践と適用に注力しています。例えば北京市は、オンライン医療サービス分野でAIによる自動診療や処方の使用禁止を打ち出しました (Beijing to ban AI-generated online medical prescriptions - Chinadaily.com.cn)。これは生成AIの誤診リスクから患者の安全を守るためであり、敏感分野で国家の安全・倫理要件を具体的に適用した例と言えます。他にも深圳市は中国初の都市レベルAI規制(2022年)を策定し、行政サービスへのAI積極活用を促進しつつ倫理委員会を設置してデータプライバシーやAI利用倫理を監督する仕組みを整えました (Artificial Intelligence in China: Shenzhen Releases First Local Regulations) (Artificial Intelligence in China: Shenzhen Releases First Local Regulations)。深圳の規則では政府機関に日常業務で可能な限りAIを活用するよう推奨する一方、市民の権利保護のためAI倫理ガイドライン委員会による指導と住民データの適切な管理を義務付けています (Artificial Intelligence in China: Shenzhen Releases First Local Regulations) (Artificial Intelligence in China: Shenzhen Releases First Local Regulations)。このように中国では、国家レベルの厳格な生成AI規制を各都市が忠実に実行し、分野ごとに細かな運用ルールを補足している状況です。国家規制との違いという点では、米欧のような地方自治体独自の倫理原則というより、国家の倫理・法的基準(安全保障、社会秩序、偏見防止、個人情報保護など)の地域実装に力点が置かれている点が特徴です。

その他の都市や最新動向

上記のほか、世界各国の自治体で生成AI活用のガバナンス整備が進んでいます。例えば中東のドバイから米国カリフォルニア州のサンノゼまで、各都市が住民サービスへのAI統合に向けた倫理フレームワークを模索しており、その共通テーマは透明性・説明責任の確保と住民の信頼醸成です (Cities are sizing up the generative AI skyline. But first they have to establish the ground rules | World Economic Forum)。G20スマートシティ連合の調査(2024年)によれば、多くの都市がガイドライン策定の初期段階にあり、安全・プライバシー・公平性など倫理的配慮を最優先事項とする傾向が共通しているといいます (Cities are sizing up the generative AI skyline. But first they have to establish the ground rules | World Economic Forum)。日本の自治体でも同様に、浦安市や千代田区、神戸市などが職員向けの生成AI利用指針を策定し、機密情報の扱いや差別のない表現、人間によるチェック体制などを定め始めています (生成AIの自治体での活用事例とガイドライン - ainow)。総じて、世界的な最新動向として**「生成AIの恩恵を公共サービスに取り入れつつ、プライバシー侵害やバイアスのリスクを抑える」というバランスを取るガイドライン策定が進行中だと言えるでしょう。 (Cities are sizing up the generative AI skyline. But first they have to establish the ground rules | World Economic Forum) (European Commission Highlights Generative AI’s Transformative Role in Public Sector - BABL AI)各自治体は自らの法制度と住民ニーズに合わせて工夫を凝らしつつ、国家レベルの規制(またはその不在)を補完する形で先行的にルールメイキング**を行っています。今後も国際的な知見共有やガイドラインのアップデートが続き、より洗練された生成AIの倫理的活用モデルが各地で確立されていくと予想されます。

Sources:

![]() 重要] このスレッドは、今回作成するAIシステムのテストを目的としたスレッドです。

重要] このスレッドは、今回作成するAIシステムのテストを目的としたスレッドです。